昨天看了小甲鱼的爬虫这章用代理和添加user agent来爬取网页的视频,对其中的内容不是十分了解,所以专门写了这篇文章来理解其中的方法。

1 | '''本代码使用代理ip登录查询ip的网站来验证代理运行是否成功, 以及opener, header的使用''' |

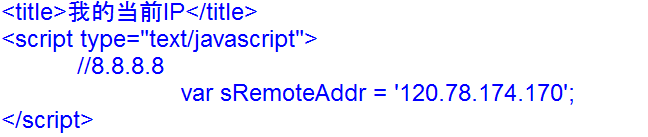

测试了一下,因为代理不稳定或者其他原因,有时会返回错误信息,多试一下就会返回包含如下信息的网页信息,可以看到他的ip地址正是我们代理的地址。

总结:

需要理解handler和opener的作用,以及是否安装opener后的处理方法

可以在哪些地方添加header,以及不同的添加方法

调用read方法后的指针问题,避免重复读取后返回空值。