2.Numpy

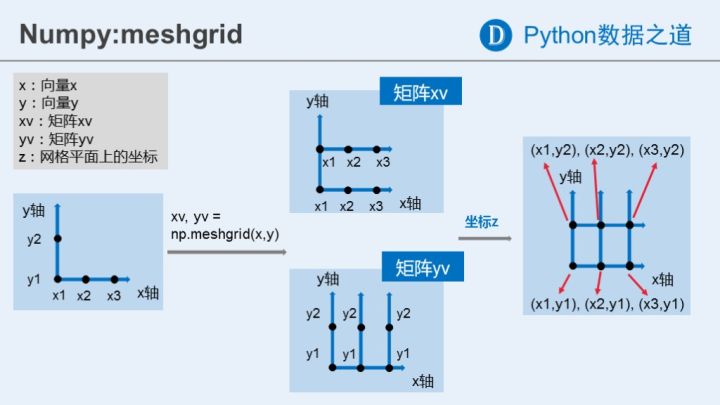

2.18 meshgrid函数

[xv,yv] = meshgrid(x,y) 将向量x和y定义的区域转换成矩阵xv和yv,其中矩阵xv的行向量是向量x的简单复制,而矩阵yv的列向量是向量y的简单复制(注:下面代码中xv和yv均是数组,在文中统一称为矩阵了)。假设x是长度为m的向量,y是长度为n的向量,则最终生成的矩阵xv和yv的维度都是 nm (注意不是mn)。

参考上图再看下面的代码,x, y为一维数组

1 | x = np.arange(3) |

4. Deep Learning From Scratch

4.2 函数求导

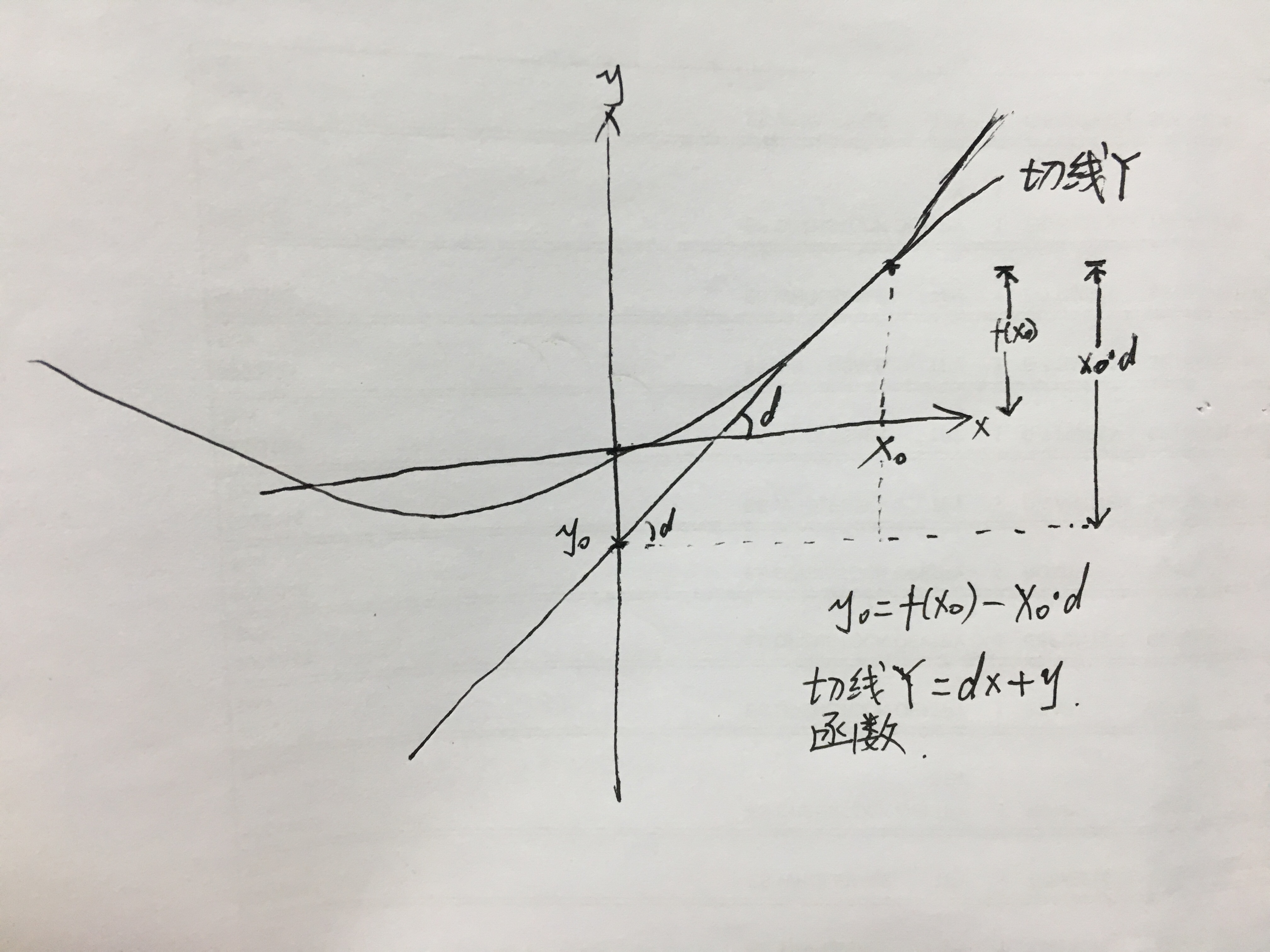

教材中求f(x)=0.01x**2 + 0.1x,当x=5时的导数,以及它的切线函数

1 | # coding: utf-8 |

推导过程:

4.3 梯度

这段代码,我主要分析了梯度的计算过程,而没有分析它绘图的过程

1 | # coding: utf-8 |

后记:

1.最近业余时间带小孩,电脑又罢工了一段时间,学习进度变得很慢。

2.感觉数学知识越来越多了,越来越复杂了。

3.还得一步一个脚印向前走。